即時港聞

科大賈佳亞團隊研AI圖像編輯及生成模型 能以圖像指令生成內容 (19:01)

目前人工智能(AI)圖像編輯及生成模型存在局限,依賴純文字指令生成圖像,且模型亦未必能準確理解氛圍、感覺等抽象概念。香港科技大學馮諾依曼研究院院長、計算機科學及工程學系講座教授賈佳亞的團隊公布其技術突破,開發出「DreamOmni2」的AI圖像生成和編輯器,除了文字指令,亦可以透過輸入圖像素材作為指令一部分,令AI除了能「看圖」、亦能「理解圖意」,再生成AI圖像,表現優於現時同類開源及閉源模型,為使用AI進行創作帶來突破。

由賈佳亞團隊研發的「DreamOmni2」,是基於全球首款基於指令的圖像編輯器「FLUX Kontext」訓練而成的模型,現時已於著名國際開源社區Github開放予公眾使用。

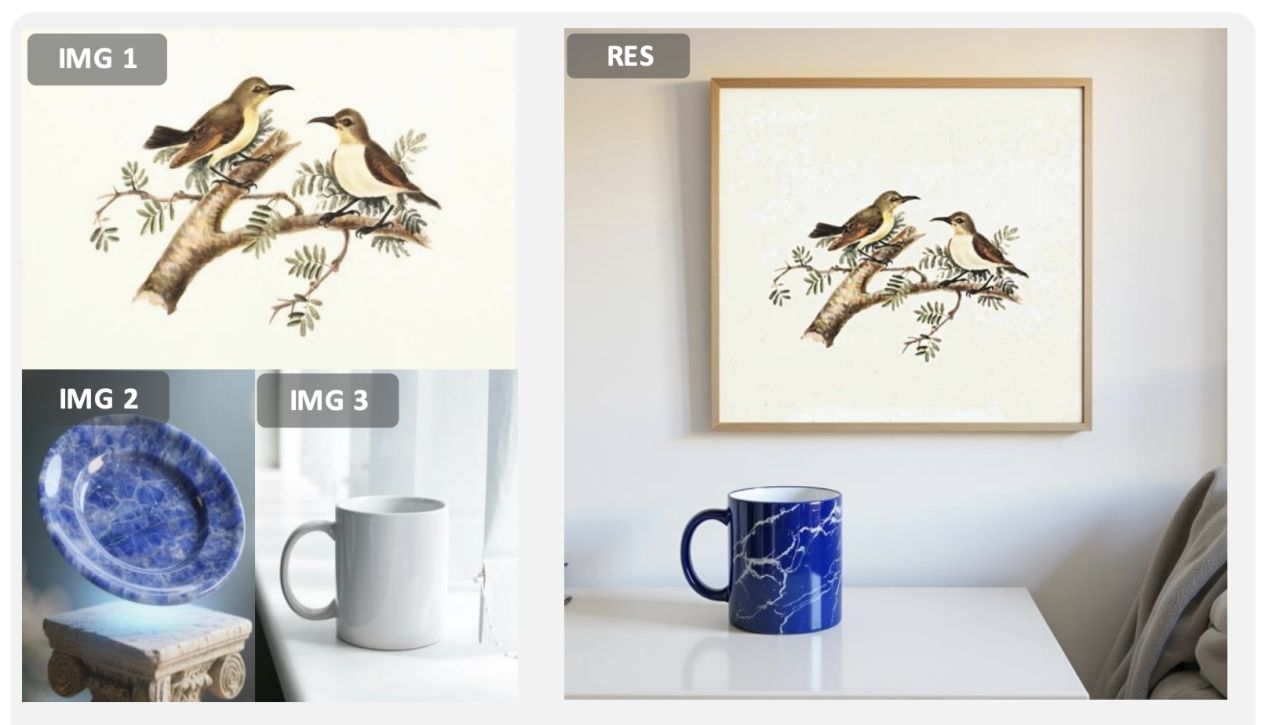

有別以往模型要靠文字指令編輯及生成AI圖像,賈團隊新研發模型可以透過輸入多張參考圖片,再編輯及生成新的AI圖像。舉例(見圖)用家擁有3張參考圖,包括雀鳥站在樹枝的畫作、藍白紋理的圓碟,以及白色的瓷杯,用家向AI模型輸入及標示3張圖片後,可以用文字指令生成一個家居場景的AI圖片,包括有一張雀鳥掛牆畫,前方有枱面有一隻藍白紋理的水杯。

科大表示,近年圖像編輯及生成的AI模型頻出,但未能克服兩大問題,包括依賴文字指令生成圖像,而文字難以準確描述人物特徵、抽象紋理等細節;其二是現有模型僅能處理有形實體,未能有效處理髮型、妝容、紋理、光影效果或風格等抽象概念,「DreamOmni2」則可解決相關問題。